Anthropic 刚刚在API中推出了提示缓存功能。这个功能可以将API提示词输入成本降低多达90%,同时还可减少多达80%的响应延迟。

那么,这功能具体是怎么工作的呢?如何使用提示词缓存功能呢?

使用提示缓存很简单,你只需要在想要缓存的内容中添加以下缓存控制属性:

"cache_control": {"type": "ephemeral"}

同时在API调用时加入这个beta标头:

"anthropic-beta": "prompt-caching-2024-07-31"

当你使用这些添加项进行API调用时,Anthropic 服务端会检查是否有相同部分的提示在最近的查询中已经被缓存过。如果是的话,就会使用缓存的提示,这样可以加快处理速度并降低成本。

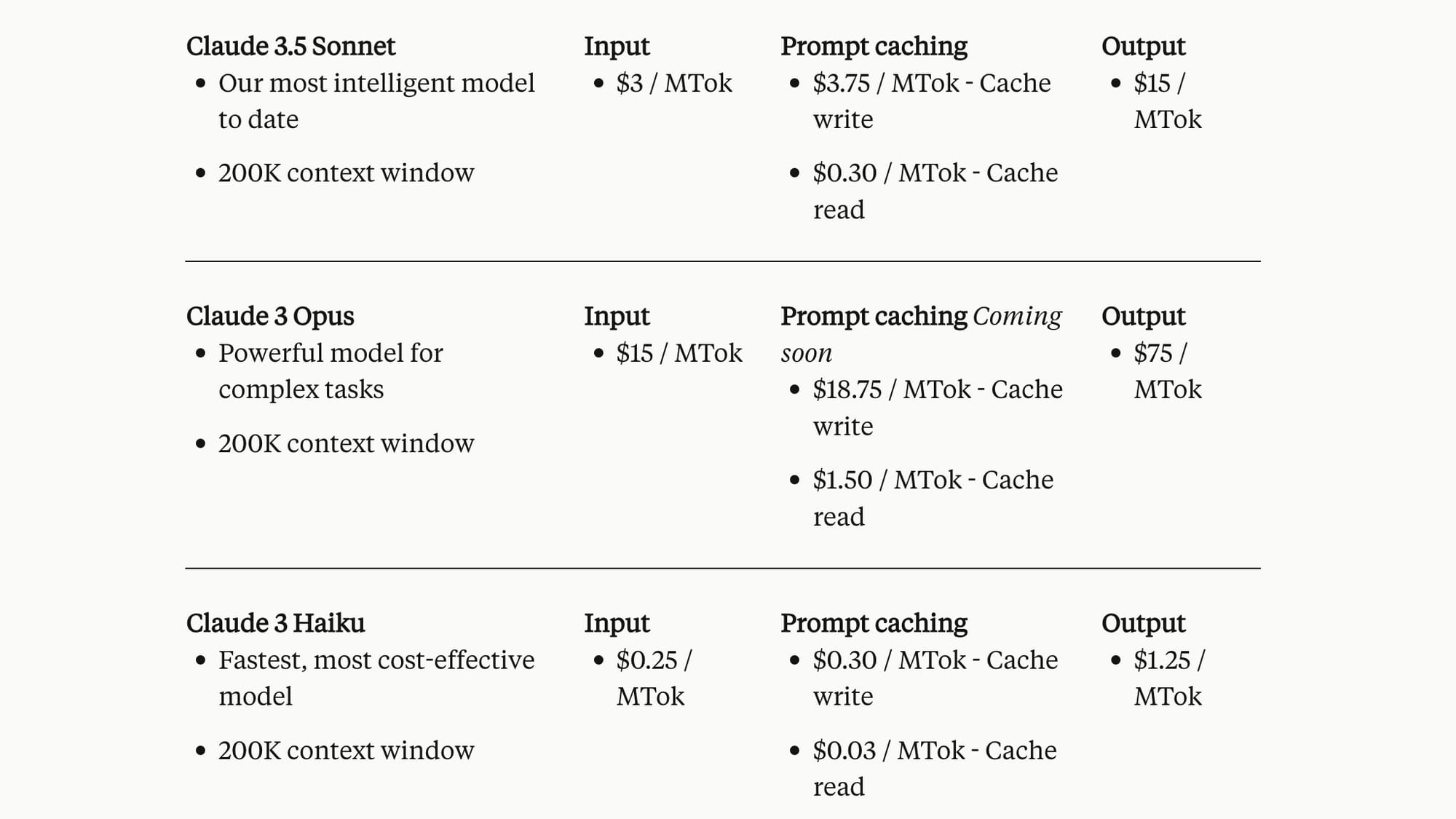

至于成本,初始的API调用会稍微贵一些(因为要将提示存储到缓存中),但之后的所有调用只需正常价格的十分之一。

我制作了一个 Artifact 互动工具,可以计算节省的成本,你可以在这里查看:

Claude Artifact

Try out Artifacts created by Claude users

提示缓存在多轮对话中也能工作。你可以逐步移动缓存控制的断点,随着对话的推进缓存之前的轮次。这在结合工具使用等功能时特别有用,因为每轮可能会添加很多内容到上下文窗口中。

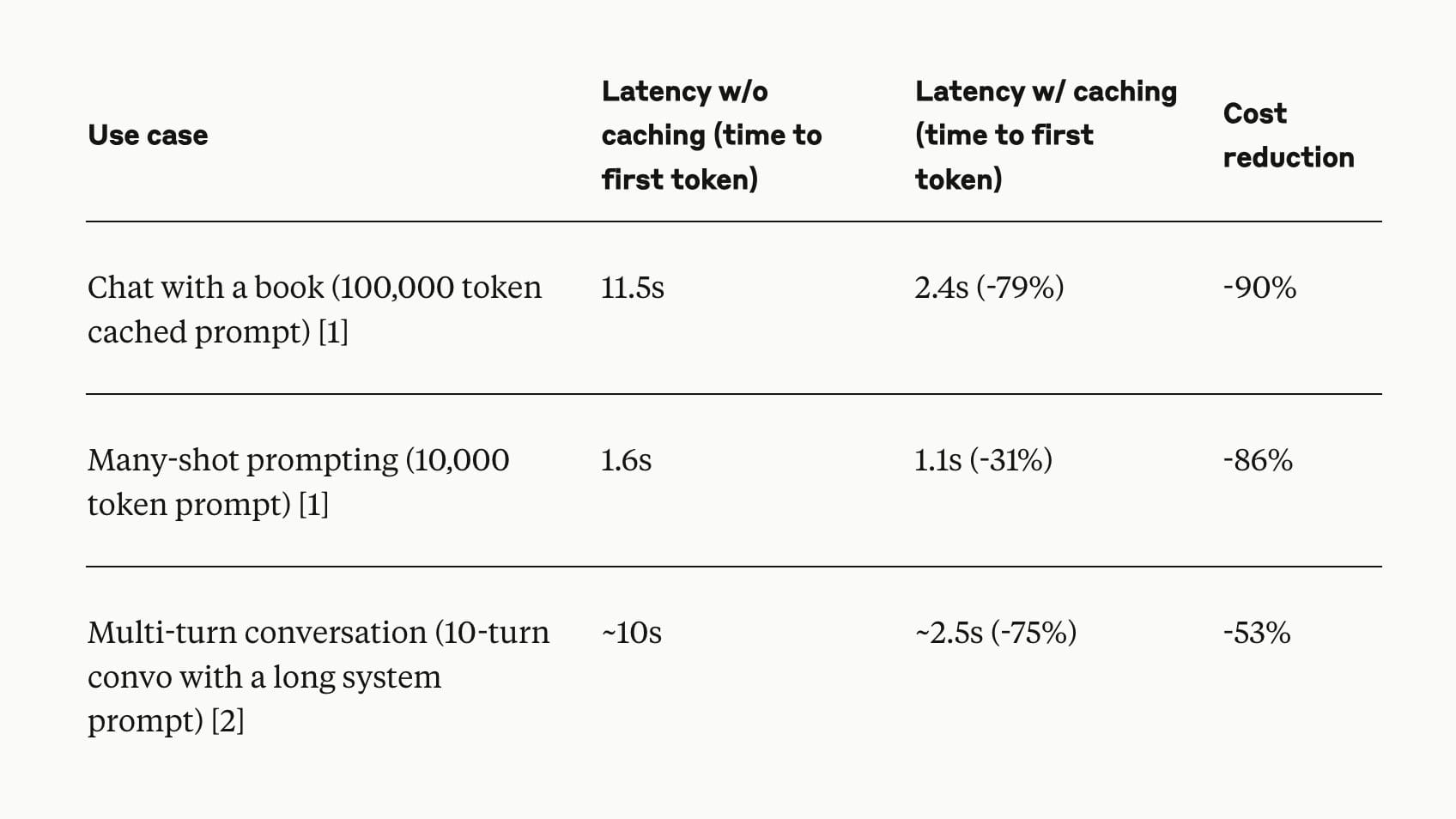

缓存带来的延迟改进非常显著。

由于提示缓存还处于测试阶段,我们预计在接下来的几周内延迟会进一步减少,特别是对于几千个token以内的短提示。

其他注意事项包括:

- 缓存的有效期为5分钟,每次使用都会重置

- 提示会在1024个token的边界上进行缓存

- 你最多可以在一个提示中定义4个缓存断点

- 对1024个token以下的短提示的缓存支持即将推出

官方文档

Prompt Caching (beta) - Anthropic