OpenAI 与 Google 在这几年间推出了革命性的人工智能工具,包括AlphaGo(自动博弈)、GPT-3(语言生成)、AlphaFold(蛋白质预测)。不知不觉中,集体智慧(Collective Intelligence)时代已经来临,所有人都中了人工智能的幻术。

其中,OpenAI 更是将魔爪伸向了图像生成领域,Dall-E(达利)系统可以藉由输入语句做出变幻无穷的图片(Text-to-Image),其中的核心灵魂— 文字图片配对引擎CLIP (Contractive Language-Image Pre-Training)是开源软件,这几个月图像演算界像是著了魔般突飞猛进,演化出看次无穷无尽的新玩法。

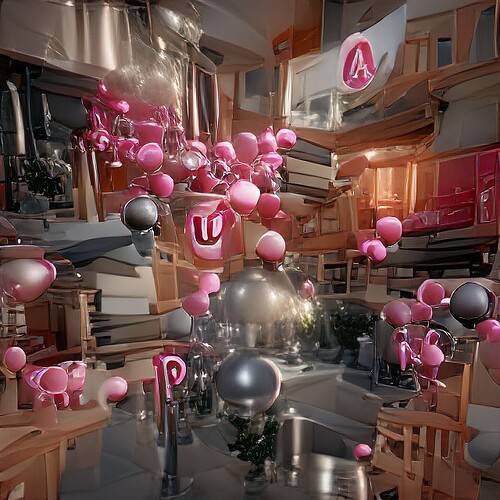

上周 Pixray 发布了一项新功能,由 AI 根据语句生成的魔幻图片(Text to Image),用户调整字句与骰图,让图片展现其意图,目前应该已算超过一万张图。

有兴趣的朋友可以在下方尝试一下Text2Image人工智能技术:

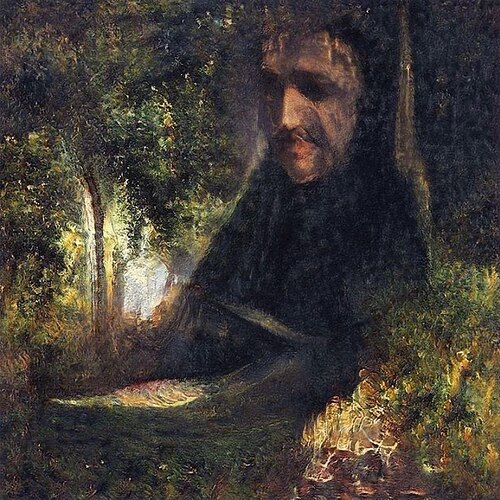

其实AI 艺术已不是新鲜事,AI 艺术先驱Mario Klingemann 于2018 年获得〈流明奖〉(Lumen Prize),其作品“屠夫之子”便是使用GAN(Generative Adversarial Network, 生成式对抗网络)训练制作;之前提到由Memo Akten 创作的分散式意识(章鱼),也是以GAN 进行创作。

“How will we be able to make a living if machines take over our creative jobs?”

by Mario Klingemann

就在十月底,Mario Klingemann 打造了一名 AI 机器艺术家Botto,与其背后支撑他的代币经济$Botto,其背后的创作原理与文前提到的Pixrary 相同,这部机器会定时接受社群提出的文字语句进行创作,其作品的交易量已经超过三千三百万台币。整个策略与行动发人省思,作品也很美。

我仔细穷究这个震撼源自何处,发现其原因不是AI 会创作、会自动演化,而是因为这两台机器背后使用的核心灵魂——CLIP算法。

这个演算法的粮食,来自全人类的网路足迹。CLIP 在诞生时不是经过事先准备好的资料集训练的,而是使用网路上能找到的一切具有文字标签的图片来训练,因此我们很难去预判CLIP 到底学到了什么。使用CLIP 时,不需要再次准备图片资料集去做训练,这个方式称为Zero-shot learning。

网路上一切有文字解释之图片,是谁的解释?解释权在谁手上?

不是科学家的解释、不是工读生的解释,是“我们”的解释。更进一步来说,是自古以来网路使用者的解释。

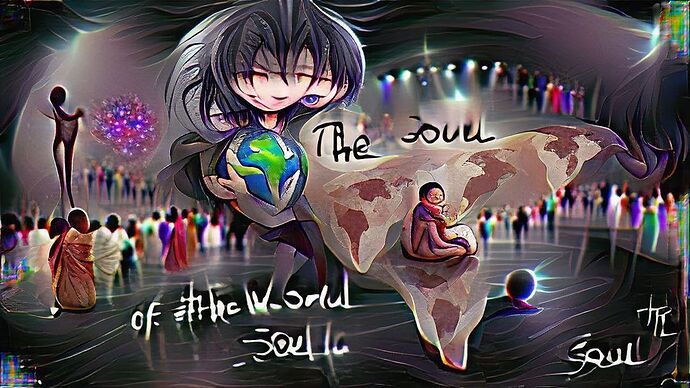

我们想到什么,记下什么,人工智能就会去消化它,学习它,成为一部没有灵魂,但有渊博知识的艺术家。人类藉由念出一段咒语来召唤人工智能,他生出一件作品给你,请问这件作品是由谁创作的呢?念咒者、人工智能、还是全人类?

打个比方,当你在Pixray 写下艾菲尔铁塔(Eiffel Tower)时,机器吐出来的图片是一个铁制尖塔,不是从艾菲尔铁塔底下往上看的样子,也不是站在塔顶往外看的样子,为什么呢?因为全人类都一致认为,艾菲尔铁塔便应该一幢从远方凝视的尖塔。

艾菲尔铁塔的符号非常明确,大家的心像大致上相同。这就是集体智慧,AI 演算法夺去了这个心智,展现给大家看。

Prompt Engineering (姑且称之为引导工程)是一种创作方式的名称,藉由不同词汇的堆叠,仿佛画笔不断将颜料堆叠在画布上。

这可不是一件容易的事,颜料有色调、运笔有技法、构图有各种消失法(拿出我国中美术班的知识…),Prompt Engineering 必须逆向工程出AI 吐哺集体心智诞生的新词汇,名词、形容词、动词、介系词、方向导引等等。

但同一个句子,机器会骰出不同的图片,因为训练集与演算法特性使然。多么诗意的创作过程呀。因为人工智能的进步,今天的人类已可以使用诗句来进行图像创作。这是全新的画布与画笔,折射出我们内心习以为成的事物。

VQGAN+CLIP 演算法原理

回过头来讲 Pixray 的演算法组合,工程师Dribnet 融合了Perception Engines、VQGAN+CLIP、Sampling Generative Networks,打造Pixray 创作平台,大家有兴趣可以上去玩玩看,简单又好玩。今天只稍微解释什么是VQGAN+CLIP。

上文提到CLIP 于今年一月由OpenAI 提出, 更新的融合技术CLIP guided GAN imagery 于今年四月由Ryan Murdoch 与Katherine Crowson 提出。十一月时已经可以看到应用其技术的GUI (图像式介面,就可你不用开终端机就能玩的服务)民间使用平台,实在令我讶异科技进步之神速,果然开源精神是一条最有效率的道路。

简单来讲, VQGAN+CLIP 是一个文字转图片的工具(text-to-image),只要设定文本导引(Text prompt),它就会给你图片。这个工具已经替AI 创作工具(Creative AI)创造新浪潮。

VQGAN 与CLIP 分别是两个神经网路架构, VQGAN 全名为Vector Quantized Generative Adversarial Network(量子化向量生成式对抗网络),使用卷积神经网络加上知名的文字演算法(Transformer, BERT & GPT的爸爸),白话一点来讲它读取文字,产出图片。CLIP 全名为Contrastive Language-Image Pre-Training (预先训练对照式语言图形演算法),它判断哪一张图片最匹配文字叙述。OpenAI 同一个时间推出的Dall-E 达利系统,是采用数亿张已知的图片资料库来训练,而CLIP 本身采用未知的网路图片进行训练。

创作者提出文字,VQGAN 产出图片,CLIP 告诉VQGAN 图片对不对,对错的准则由网路全人类的结晶决定,以此方式反覆迭代到创作者说停为止。这个工具将产生巨大的创作能量,现在只是一个开头而已。

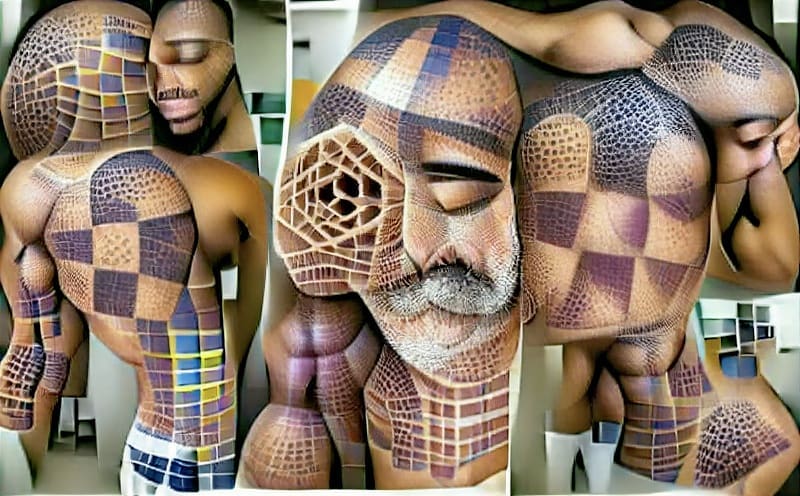

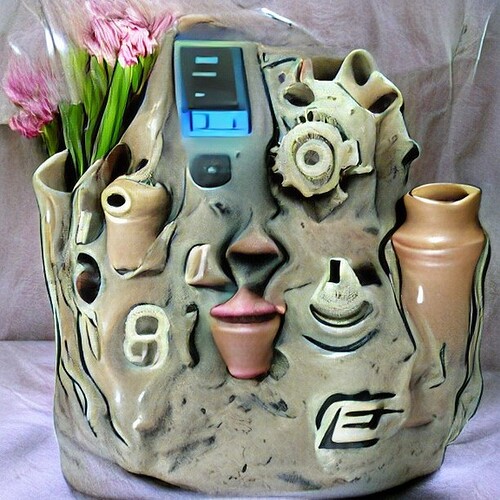

VQGAN+CLIP的一些案例

不需要改变数据集,只需要给CLIP下达的命令中把“虚幻引擎”几个字加上,再让CLIP去指挥GAN,图像就立马变成了高大上的CG艺术风。

文字中加入虚幻引擎这个技巧,最早由Aran Komatsuzaki发在推特上,吸引了大量CV圈的人来围观。

还可以指定成“彩色铅笔风格”:

或者,加上“3D photo inpainting”可以生成立体构图:

心动不如行动,快来试试吧:Google Colab